这段视频脚本介绍了AI技术在面部和嘴唇同步3D动画中的应用。通过与Nvidia合作,reolution提供了一套全面的工作流程,帮助用户进行多语言面部和嘴唇同步动画制作。通过安装插件和使用工具,用户可以利用AI技术从音频到面部生成动画,实现简单的角色表情和动画效果。整个过程简单易行,为3D内容创作者和动画师提供了更多创作可能性。

AUDIO2FACE人工智能语音动画官网

关键时刻:

00:00 3D内容创作者和动画师在制作动画角色时经常面临的挑战之一是面部和嘴唇同步动画。最新的Nvidia合作带来了全面集成的工作流程,为多语言面部和嘴唇同步动画制作提供了简化的角色面部表现。

-Nvidia的音频到面部技术为角色面部表现提供了简化的方式,通过Nvidia的Omniverse,用户可以获得全面的解决方案,包括面部和全身动画。

-用户可以通过Omniverse将音频转换为面部表现,然后将数据传回iclone进行进一步的调整,这些表现是通过简单的音频输入自动生成的。

03:43 导出文件后,打开audio to face文件夹,选择AI模型,选择音轨,调整情绪,生成表情,导出Json文件至iclone。

-选择适合模型特征的AI模型,有男性和女性两种类型,根据模型特征选择合适的模型。

-通过音轨驱动模型,调整情绪,生成面部表情,可以根据需要添加或删除表情,进行细化调整。

Reallusion 利用 NVIDIA AI 动画技术,将 Character Creator、iClone 和 Audio2Face 集成到一个无缝解决方案中。展示用于多语言面部唇形同步动画制作的人工智能驱动的工作流程,并扩展 Audio2Face 与跨平台 3D 角色规范的兼容性。凭借广泛的面部编辑功能,它简化了 iClone 角色动画向领先 3D 引擎(例如 Blender、Unreal Engine、Unity 等)的导出。 Omniverse 用户还可以享受针对 CC 角色的面部和全身动画的全面解决方案。

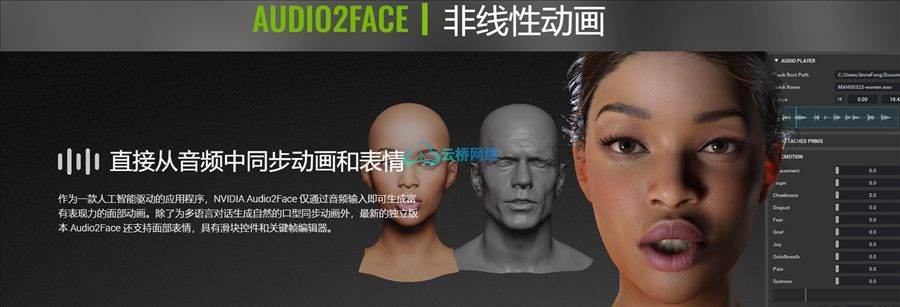

直接从音频中同步动画和表情

作为一款人工智能驱动的应用程序,NVIDIA Audio2Face 仅通过音频输入即可生成富有表现力的面部动画。除了为多语言对话生成自然的口型同步动画外,最新的独立版本 Audio2Face 还支持面部表情,具有滑块控件和关键帧编辑器。

多语言口型同步和歌唱动画

与大多数以英语为中心的口型同步解决方案不同,Audio2Face 以其从任何语言(包括歌曲和乱码)生成动画的卓越能力而脱颖而出。除了标准 AI 模型 Mark 之外,还可以使用 Clarie,这是一种专为精通亚洲语言的女性角色量身定制的全新深度学习模型。 Clarie 友好的语调非常适合与客户互动。

Audio2Face 的 CC 角色自动设置插件是 NVIDIA 和 Reallusion 合作的成果,将手动 18 个步骤的过程压缩为一个步骤。通过导入 CC 角色并选择训练模型(Mark 或 Claire),艺术家可以立即见证与音频文件同步的栩栩如生的说话动画。尝试使用运动滑块、自动表达式,甚至设置关键帧。最终确定的动画可以发送到 iClone 进行进一步制作。

1、登录后,打赏30元成为VIP会员,全站资源免费获取!

2、资源默认为百度网盘链接,请用浏览器打开输入提取码不要有多余空格,如无法获取 请联系微信 yunqiaonet 补发。

3、分卷压缩包资源 需全部下载后解压第一个压缩包即可,下载过程不要强制中断 建议用winrar解压或360解压缩软件解压!

4、云桥CG资源站所发布资源仅供用户自学自用,用户需以学习为目的,按需下载,严禁批量采集搬运共享资源等行为,望知悉!!!

5、云桥CG资源站,感谢您的赞赏与支持!平台所收取打赏费用仅作为平台服务器租赁及人员维护资金 费用不为素材本身费用,望理解知悉!

6、For users outside China, if Baidu Netdisk is not convenient for downloading files, you can contact WeChat: yunqiaonet to receive a Google Drive download link.